Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

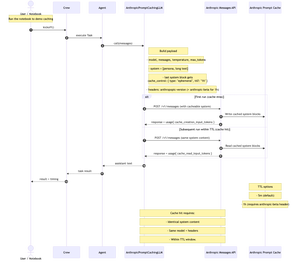

Acabo de publicar un cuaderno de Jupyter Notebook conciso y paso a paso que muestra cómo crear un LLM personalizado para @crewAIInc que llama a la API de mensajes de @AnthropicAI e implementa el almacenamiento en caché de solicitudes.

Bueno, ¿qué es el almacenamiento en caché rápido y cuándo debe usarlo en su equipo?

Es una forma de almacenar en caché la parte larga y repetida de su mensaje (generalmente el contexto del sistema) entre llamadas a la API. lo envía una vez, luego las llamadas posteriores lo reutilizan; reducir el costo de entrada en ~ 90% y acelerar el tiempo hasta el primer token en ~ 85% para indicaciones largas, siempre que el contenido del sistema + modelo + encabezados permanezcan iguales y esté dentro de TTL (5 millones predeterminados, 1 hora beta).

Esto funciona muy bien para tripulaciones parlanchinas de varios turnos. También es útil cada vez que su equipo reutiliza un contexto de sistema largo y estable en todas las tareas (piense: manual, especificaciones, resumen de la base de código). Si su sistema / contexto cambia cada llamada, el almacenamiento en caché no ayudará mucho.

el libro de cocina usa "Frankenstein" del Proyecto Gutenberg para demostrar el almacenamiento en caché con un contexto real y largo.

diagrama a continuación: primero ejecute escrituras en caché; las ejecuciones posteriores leen de la caché cuando el contenido del sistema, el modelo y los encabezados coinciden con el TTL.

repo + notebook en comentarios.

886

Populares

Ranking

Favoritas