Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

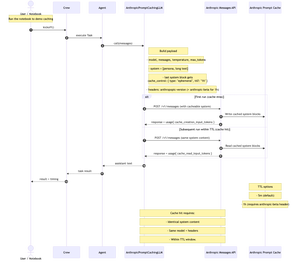

Saya baru saja menerbitkan buku catatan Jupyter langkah demi langkah yang ringkas yang menunjukkan cara membangun LLM khusus untuk @crewAIInc yang memanggil Messages API @AnthropicAI dan mengimplementasikan penembolokan prompt.

Nah, apa itu Prompt Caching dan kapan Anda harus menggunakannya di kru Anda?

Ini adalah cara untuk menyimpan cache bagian prompt Anda yang panjang dan berulang (biasanya konteks sistem) di antara panggilan API. Anda mengirimkannya sekali, lalu panggilan berikutnya menggunakannya kembali; Memotong biaya input sebesar ~90% dan mempercepat waktu-ke-token pertama sebesar ~85% untuk perintah yang panjang, selama konten sistem + model + header tetap sama dan Anda berada dalam TTL (default 5M, beta 1 jam).

Ini sangat cocok untuk kru multi-giliran yang cerewet. Juga berguna setiap kali kru Anda menggunakan kembali konteks sistem yang panjang dan stabil di seluruh tugas (pikirkan: buku pedoman, spesifikasi, ringkasan basis kode). Jika sistem/konteks Anda mengubah setiap panggilan, caching tidak akan banyak membantu.

buku masak menggunakan "Frankenstein" dari Project Gutenberg untuk mendemonstrasikan caching dengan konteks yang nyata dan panjang.

diagram di bawah ini: Lari pertama menulis ke cache; eksekusi berikutnya dibaca dari cache ketika konten sistem, model, dan header cocok dalam TTL.

Repo + Notebook di komentar.

876

Teratas

Peringkat

Favorit