Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

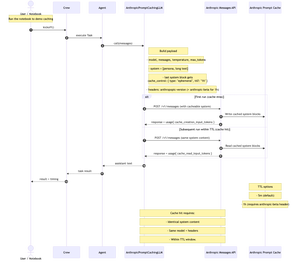

Ho appena pubblicato un notebook Jupyter conciso e passo-passo che mostra come costruire un LLM personalizzato per @crewAIInc che chiama l'API Messages di @AnthropicAI e implementa la memorizzazione nella cache dei prompt.

Bene, cos'è la memorizzazione nella cache dei prompt e quando dovresti usarla nel tuo team?

È un modo per memorizzare nella cache la parte lunga e ripetuta del tuo prompt (di solito il contesto di sistema) tra le chiamate API. Lo invii una volta, poi le chiamate successive lo riutilizzano; riducendo il costo di input di circa il 90% e accelerando il tempo fino al primo token di circa l'85% per i prompt lunghi, a patto che il contenuto del sistema + modello + intestazioni rimangano gli stessi e tu sia entro il TTL (5 minuti di default, 1 ora in beta).

Funziona bene per team chiacchieroni e multi-turno. Utile anche ogni volta che il tuo team riutilizza un lungo e stabile contesto di sistema tra i compiti (pensa: manuale, specifiche, riepilogo del codice). Se il tuo sistema/contenuto cambia ad ogni chiamata, la memorizzazione nella cache non aiuterà molto.

Il ricettario utilizza "Frankenstein" di Project Gutenberg per dimostrare la memorizzazione nella cache con un contesto lungo e reale.

Diagramma qui sotto: la prima esecuzione scrive nella cache; le esecuzioni successive leggono dalla cache quando il contenuto del sistema, il modello e le intestazioni corrispondono entro il TTL.

Repo + notebook nei commenti.

881

Principali

Ranking

Preferiti