Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

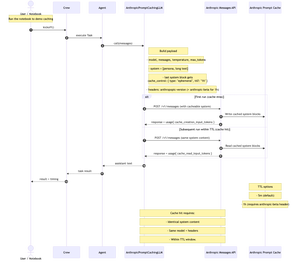

Jeg har nettopp publisert en kortfattet, trinnvis jupyter-notatbok som viser hvordan du bygger en tilpasset LLM for @crewAIInc som kaller @AnthropicAI Messages API og implementerer hurtigbufring.

Vel, hva er rask caching og når bør du bruke det i mannskapet ditt?

Det er en måte å bufre den lange, gjentatte delen av ledeteksten (vanligvis systemkontekst) mellom API-kall. du sender den én gang, og deretter bruker påfølgende anrop den på nytt; kutte inngangskostnadene med ~90 % og øke tiden til første-token med ~85 % for lange spørsmål, så lenge systeminnholdet + modellen + overskriftene forblir de samme og du er innenfor TTL (5m standard, 1h beta).

Dette fungerer utmerket for pratsomme mannskaper med flere svinger. Også nyttig når mannskapet ditt gjenbruker en lang, stabil systemkontekst på tvers av oppgaver (tenk: håndbok, spesifikasjon, kodebasesammendrag). Hvis systemet/konteksten endrer hver samtale, vil caching ikke hjelpe mye.

kokeboken bruker "Frankenstein" fra Project Gutenberg for å demonstrere caching med ekte, lang kontekst.

Diagram nedenfor: Første kjøring skriver til cache; påfølgende kjøringer leses fra hurtigbufferen når systeminnhold, modell og overskrifter samsvarer i TTL.

Repo + Notebook i kommentarer.

856

Topp

Rangering

Favoritter