トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

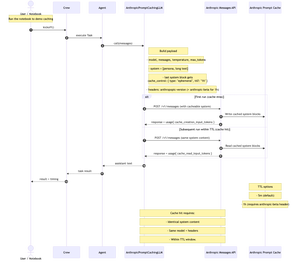

私は、@AnthropicAI のメッセージ API を呼び出し、プロンプト キャッシュを実装する @crewAIInc 用のカスタム LLM を構築する方法を示す、簡潔でステップバイステップの Jupyter ノートブックを公開しました。

さて、プロンプトキャッシュとは何ですか、そしていつクルーで使用する必要がありますか?

これは、API 呼び出し間でプロンプトの長い繰り返し部分 (通常はシステム コンテキスト) をキャッシュする方法です。一度送信すると、後続の呼び出しで再利用されます。システムコンテンツ+モデル+ヘッダーが同じままで、TTL(デフォルト5m、ベータ1時間)内である限り、入力コストを~90%削減し、最初のトークンまでの時間を~85%短縮します。

これは、おしゃべりでマルチターンの乗組員に最適です。また、スタッフがタスク間で長く安定したシステムコンテキストを再利用する場合にも役立ちます (ハンドブック、仕様、コードベースの要約など)。システム/コンテキストが呼び出しごとに変更される場合、キャッシュはあまり役に立ちません。

この料理本では、プロジェクト・グーテンベルクの「フランケンシュタイン」を使用して、実際の長いコンテキストでキャッシュをデモンストレーションしています。

下の図:最初の実行はキャッシュに書き込みます。後続の実行は、システム コンテンツ、モデル、およびヘッダーが TTL 内で一致する場合にキャッシュから読み取られます。

リポジトリ+ノートブックをコメントで。

878

トップ

ランキング

お気に入り